Roblox investe em segurança infantil com IA avançada

Roblox está melhorando suas medidas de segurança para bate-papos infantis usando IA. Esta decisão ocorre no momento em que a plataforma se ajusta a um público crescente, incluindo usuários mais velhos. Com bilhões de mensagens de bate-papo enviadas todos os dias e uma ampla variedade de conteúdo criado por usuários, Roblox enfrenta um desafio especial ao moderar a plataforma para garantir um ambiente seguro e amigável para jogadores de todas as idades.

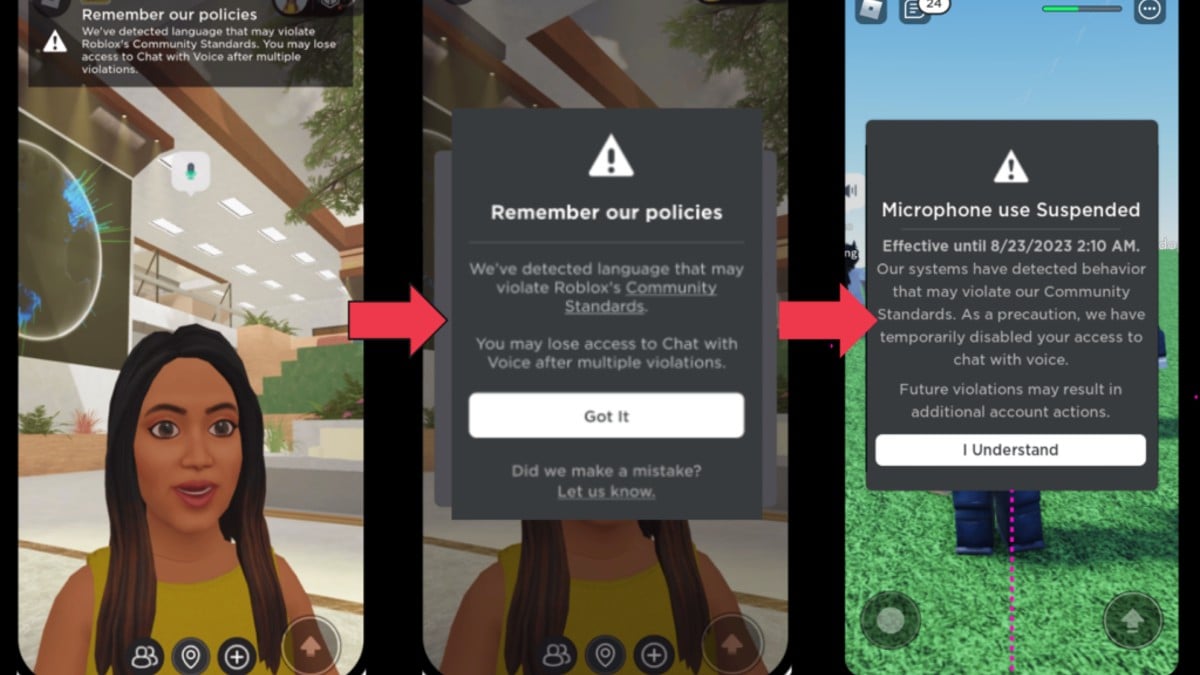

Abordagem de segurança do Roblox está centrado em uma combinação de inteligência artificial e conhecimento humano. O filtro de texto da empresa, refinado para o idioma específico do Roblox, agora pode identificar conteúdo que viola a política em todos os idiomas suportados. Isto é particularmente importante considerando o recente lançamento de traduções de chat de IA em tempo real. Além disso, um sistema interno original modera as comunicações de voz em tempo real, sinalizando falas inadequadas em segundos. Para complementar isso, notificações em tempo real informam aos usuários quando suas abordagens de fala violam as diretrizes da Roblox, reduzindo as denúncias de abuso em mais de 50%.

Roblox modera cuidadosamente o conteúdo visual usando tecnologia de visão computacional para avaliar avatares, acessórios e modelos 3D criados pelo usuário. Os itens podem ser aprovados automaticamente, sinalizados para revisão humana ou rejeitados quando necessário. Este processo também examina as partes individuais de um modelo para evitar que combinações potencialmente prejudiciais sejam ignoradas.

Esta é apenas uma das muitas coisas que Roblox fez. Eles apoiaram um projeto de lei na Califórnia para a segurança infantil, o que é um grande negócio. No entanto, mesmo com a pressão sobre as condições de pagamento, eles não pensam que estão a explorar as crianças com os seus métodos de pagamento.

A empresa está criando sistemas multimodais de IA que são treinados em vários tipos de dados para melhorar a precisão. Essa tecnologia ajuda a Roblox a identificar como diferentes elementos de conteúdo podem levar a situações prejudiciais que uma IA unimodal pode não detectar. Essencialmente, é um monte de IAs trabalhando juntas, em vez de uma única IA que deve cuidar de tudo. Por exemplo, um avatar de aparência inocente pode causar problemas quando combinado com uma mensagem de texto de assédio. Um bom exemplo é quando um logotipo da Netflix é usado como imagem de perfil para um usuário do TikTok, e então o nome de usuário de seis letras é uma palavra proibida que começa com N, mas não usa N (porque a imagem do perfil faz isso para eles ).

Embora o uso da automação seja importante para lidar com uma grande quantidade de trabalho de moderação, Roblox enfatiza a necessidade contínua de envolvimento humano. Os moderadores ajustam os modelos de IA, lidam com situações complicadas e garantem a precisão geral. Especificamente para investigações sérias, como as relacionadas com extremismo ou perigo infantil, equipas internas especializadas tomam medidas para identificar e lidar com as pessoas más.

Publicar comentário